人間の脳を模倣した?「ニューラルネットワーク」とは何か。

以前のエントリ「深層学習(Deep Learning)とは?非エンジニアが説明してみた。」ではディープラーニングについて解説しましたが、ディープラーニングを理解するためには、その根幹となる仕組み、ニューラルネットワークを理解するのが先決ということで、そのさわりについて述べました。

今回は、そのニューラルネットワークと人類の「脳」との関係、成り立ちについて解説します。

人間の脳細胞の仕組み

ニューラルネットワークは、人間の脳の神経細胞(ニューロン)の仕組みをプログラム上で模したモデルと言われています。

まずは人間の脳の仕組みと働きについて、説明します。

脳の構造

人間の脳は神経細胞による巨大なネットワーク構造になっていて、それを構成しているのが「神経細胞」です。

神経細胞は、電気信号を発して情報をやりとりする細胞で、その数は大脳で数百億個、小脳で約1000億個、全体では千数百億個に及びます。

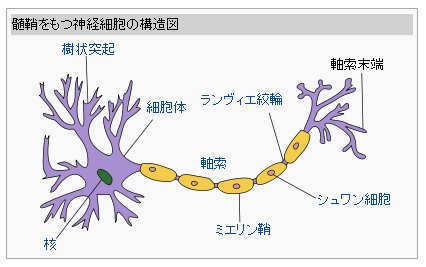

神経細胞は、それぞれを結ぶ「軸索」と、生い茂る木の枝のようにさまざまな方向に分岐している「樹状突起」でつながり合い、ネットワーク構造の「神経回路」を形成しています。

神経細胞は、細胞体と軸索と樹状突起で一つの単位「ニューロン(神経単位)」とも呼びます。

画像出典:Wikipedia(神経細胞)

細胞体の大きさは、大きいものは0.1mm以上になりますが、小さなものは0.005mm程度の大きさです。

大脳ではわずか1立方ミリメートルに10万個以上の神経細胞が詰まっていて、脳全体の神経細胞から出ている軸索や樹状突起をすべてつなげると、100万km以上にもなります。

人間の脳が以下に密度の高い、複雑なネットワークであるかがわかります。

脳が働くとき

ニューロンの「樹状突起」が他の神経細胞から電気信号の情報(インパルス)を受け取る役割をし、「樹状突起」が受け取った電気信号は「細胞体」から「軸索」を通り次の神経細胞に伝達していくという仕組みで情報処理を行っています。

それぞれのニューロンは約1万の他のニューロンにつながっていて、じつは病院などで測定する「脳波」は、この神経細胞ネットワークを流れたインパルスを外部から計ったものです。

電気信号の強さ

「軸索」と「樹状突起」の接続された部分には隙間(シナプス)があり、直接つながっているわけではありません。

シナプスまで届いた電気信号は神経伝達物質とともに次の細胞に伝達されますが、その量が一定になりはじめて次の細胞に電気信号が生まれ情報が伝わる(「発火」する)仕組みになっています。

人工知能のニューラルネットワークとは

上記のような構造をコンピュータ上に再現したらどうか、という発想は当然かも知れません。

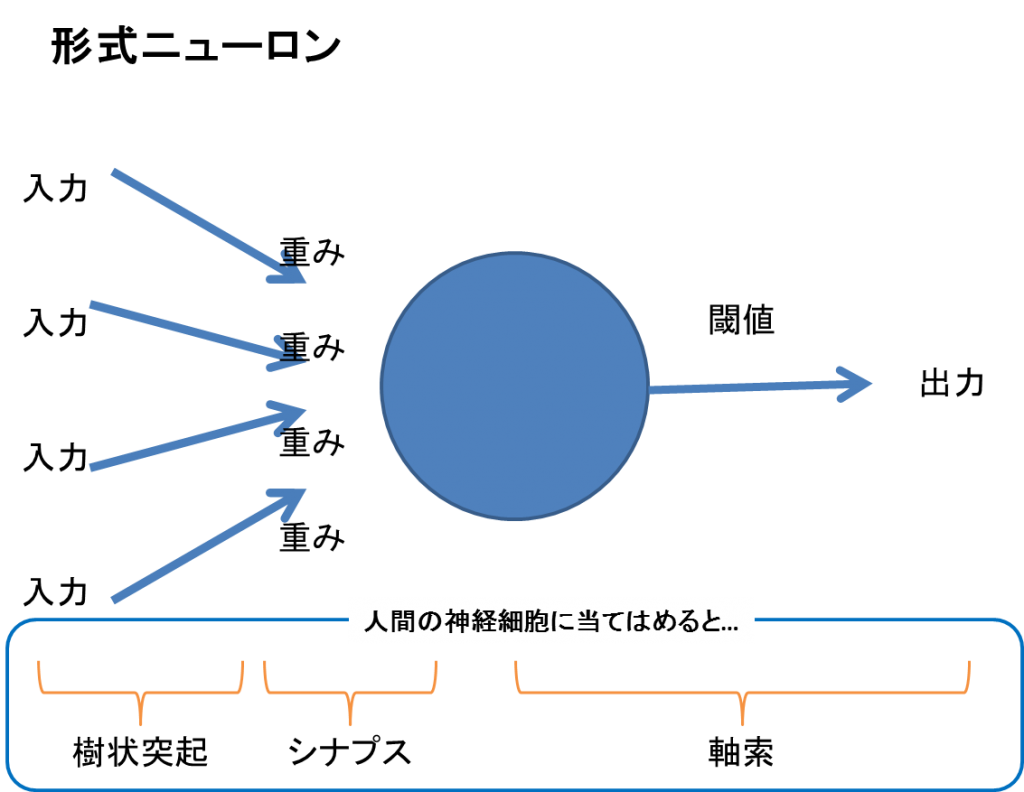

このニューロンの構造を試す発想は1943年ごろには生まれており、神経生理学者・外科医であるウォーレン・マカロックと論理学者・数学者であるウォルター・ピッツが発表したのが世界初の人工ニューロン(形式ニューロン)です。

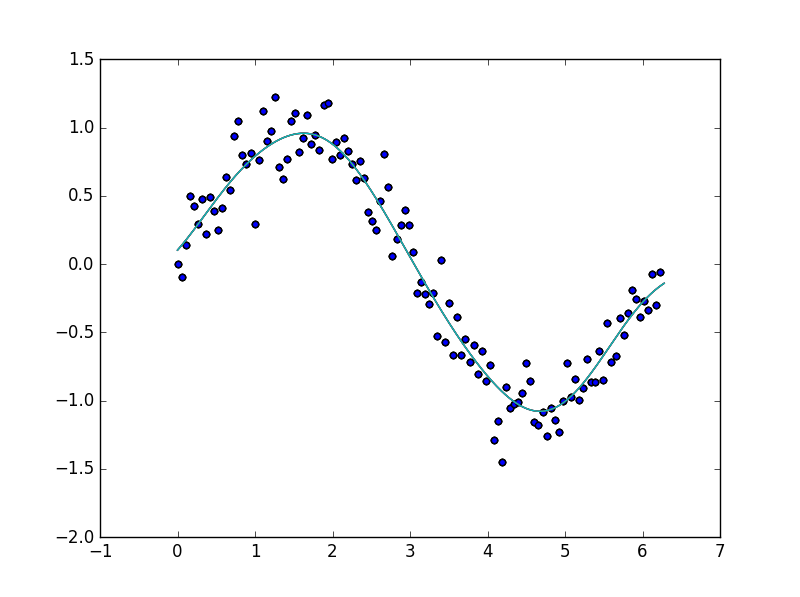

上の図に形式ニューロンの図と人間のニューロンの構造に当てはめてみました。

インパルスは一定の量の電気信号を受けて情報伝達しますが、形式ニューロンでは「入力×重み<閾値」といった計算で出力に至ります。

(形式ニューロンの場合には通常の場合入力、出力とも0か1かです。)

ニューラルネットワーク発展の歴史

パーセプトロン

その後1957年にアメリカの心理学者フランク・ローゼンブラットが考案したのがパーセプトロンです。

パーセプトロンはパターン認識を行うことができ学習することが出来たことから一時的なブームを引き起こしますが、「線形分離可能な問題」しか対応する事ができないことを指摘されそのブームは終焉します。

バックプロパゲーションの発表

それから30年ほど過ぎた1986年にはアメリカの認知心理学者のデビッド・ラメルハートらによる多層パーセプトロンを使用したバックプロパゲーション(誤差逆伝播学習法)というアルゴリズムが考案されます。

これは「隠れ層」を加えた2層以上のパーセプトロンを使用することで「非線形分離可能な問題」を解くことができるようになったものの、同時にアルゴリズム調整が困難になってしまうという問題にバックプロパゲーションを使うことで多層構造でも重みの調整を可能にし、適切な学習ができるようになるというブレイクスルーでした。

そしてディープラーニングへ・・・

形式ニューロンを発展させる形でパーセプトロンが登場し、限定的ですが学習が可能となり、その限界もパーセプトロンを多層にすることで学習できるようになりました。

さらに多層にすることでもっと機能が向上するのではないかと考えてしまうのは当然です。

しかし、多層にした複雑なネットワークでは上手く学習することが出来ないという現象が起こりました。

それぞれの層で重みをチューニングしても、全体のネットワークの中で均質になってしまい重みづけの意味が失われてしまう問題がでてきたのです。(勾配消失問題)

これを解決するための方法の一つとして、自己符号化器による事前学習で初期値設定することがあります。

ただし、なぜうまく学習できるようになるのか、ということは理論的には解明されておらず、経験則で上手くいったのでノウハウとして使っている、という状況です。

最後に

人間の小脳と大脳ではニューロンのネットワーク構造の複雑さに違いがあり、小脳は極めて浅い(3層)ということが判明しています。

深い層によるネットワーク構造は情報伝達や処理に時間がかかることから、それぞれの役割に応じた構造になっているのだと思われますが、生物学的にも小脳の発達が大脳の発達に先んじており、人工知能研究とも合致するところが興味深いです。

ただ、ニューラルネットワークは人間の脳を模倣している、という表現には若干の誤謬があります。

あくまでも関数のモデルとして、神経細胞の挙動に発想したものとして「人工ニューラルネットワーク」は存在していて、決して人工脳そのものを生み出すようなものではないということは改めて冷静に理解しておくべきでしょう。

その一方で小脳パーセプトロン仮説という研究もあり、人工知能アルゴリズムの研究からのフィードバックが脳科学の発展につながるという面白い流れにもなっています。

人間存在の深淵を除くことができるかもしれないという意味でも、さらなる人工知能・ニューラルネットワークの研究を期待してしまいます。

-

お問い合わせ

SiTest の導入検討や

他社ツールとの違い・比較について

弊社のプロフェッショナルが

喜んでサポートいたします。 -

コンサルティング

ヒートマップの活用、ABテストの実施や

フォームの改善でお困りの方は、

弊社のプロフェッショナルが

コンサルティングいたします。

今すぐお気軽にご相談ください。

今すぐお気軽に

ご相談ください。

(平日 10:00~19:00)

今すぐお気軽に

ご相談ください。

0120-90-5794

(平日 10:00~19:00)

グラッドキューブは

「ISMS認証」を取得しています。

認証範囲:

インターネットマーケティング支援事業、インターネットASPサービスの提供、コンテンツメディア事業

「ISMS認証」とは、財団法人・日本情報処理開発協会が定めた企業の情報情報セキュリティマネジメントシステムの評価制度です。