人工知能に道徳的な意思決定を。MITの「モラルマシーン」

当SiTestブログでは人工知能活用の将来像の一つとして、何度か自動運転車についても取り上げてきました。

技術的な問題もさまざま残っていますが、重要な問題として万が一事故の責任は誰が取るのか、トロッコ問題(危機が迫ったときに誰の命を最優先するかという犠牲を伴う意思決定の問題)を人工知能はどのように解決するか、など倫理的なクリアできていない問題も存在しており、普及の大きな壁として立ちふさがるだろうと考えられています。

トロッコ問題に人間はどう対応するのか

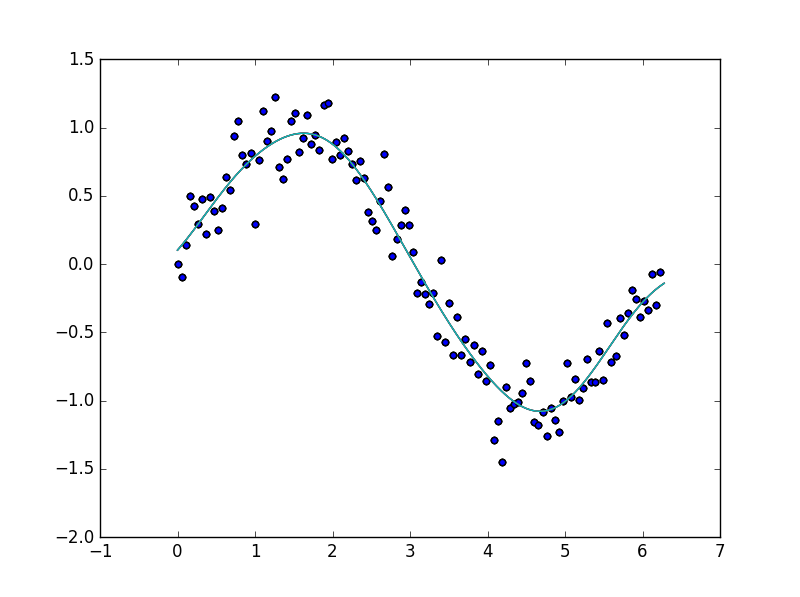

自動運転車は搭乗者の命を優先すべきか、それとも歩行者の人命を尊重すべきなのか。

その答えを人工知能に問う前に人間たちはどのように考えているのでしょうか

答えは永遠に出ないのでしょうが、マサチューセッツ工科大学(MIT)がアンケートを取って研究に活かそうとしています。

その名も「モラル・マシン」です。

モラル・マシンは文字通り、

自動運転車を用いた人工知能の道徳的な意思決定に関して、人間の視点を収集するためのプラットフォーム

として運営されており、

(1)人工知能による道徳的意思決定についての異なる意見の収集、可視化、(2)またその意思決定がもたらすモラル上の問題に関する議論の活性化

を目的とされています。

モラル・マシンを試してみた。

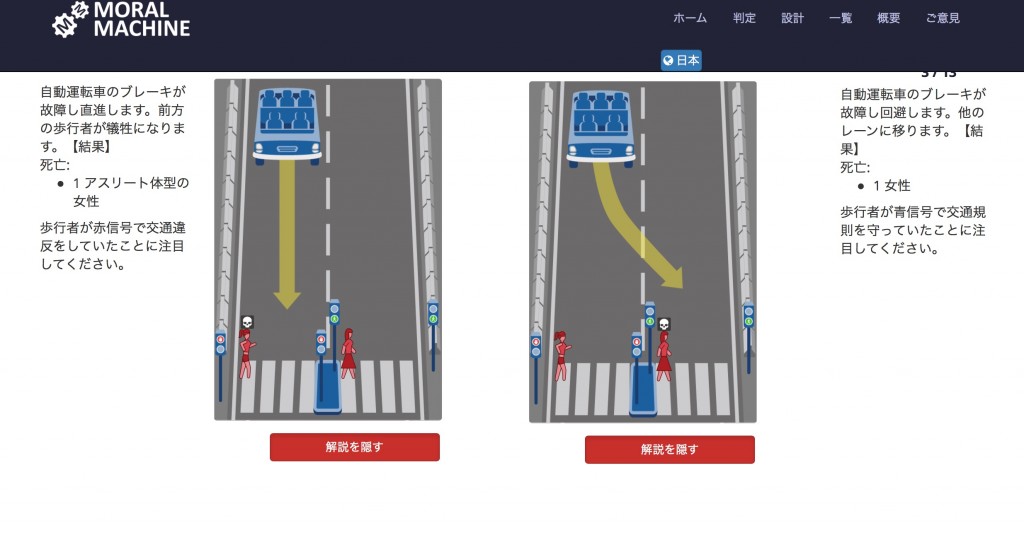

さまざまな横断歩道のシチュエーションが提示され、あなたは二者択一を迫られます。

犠牲の対象となるのは、男性・女性、高齢者や乳幼児、経営者や犯罪者、犬や猫など多岐にわたり、

歩行者が赤信号を無視しているシチュエーションなども設定できます。

また、事故の影響は「死亡」「ケガ」「未確定」の段階があり、その程度も考慮しながらユーザーは判断を下すことになります。

決まっていることは、判断には絶対に犠牲が強いられるという点です。

また、第三者としてこの状況を観察しているユーザーに事故の影響は及びません。

このトロッコ問題は「設計」でユーザーが作り、公開することができ、ユーザーはディスカッション掲示板でコメントをつけることが可能です。

Moral Machine – Human Perspectives on Machine Ethics(YouTube)

実際のテストの様子は上記の映像を確認するのがスムーズですが、実際に自分が運転している車であればサイトの問題のように答えを出せるとは思えません。

手をこまねいている間に大惨事、というのが関の山ではないでしょうか。

人工知能だからこそ、「集計されたモラル」に従って冷静に事故を起こすことができるのかもしれません。

最後に

審査に最後まで答えると、回答者の判断の傾向が判定されます。

この結果がアンケートとしてデータ化されるようですが、サンプルとして含めないことも可能です。

なぜならこのモラル・マシンは最初にアンケートの趣旨がわかっていてはサンプルとして適切でないからです。

事前の情報が回答に影響を及ぼすことが考えられますので、できるだけシェアするときは情報を隠し、先入観のない状況で試してもらってください。

-

お問い合わせ

SiTest の導入検討や

他社ツールとの違い・比較について

弊社のプロフェッショナルが

喜んでサポートいたします。 -

コンサルティング

ヒートマップの活用、ABテストの実施や

フォームの改善でお困りの方は、

弊社のプロフェッショナルが

コンサルティングいたします。

今すぐお気軽にご相談ください。

今すぐお気軽に

ご相談ください。

(平日 10:00~19:00)

今すぐお気軽に

ご相談ください。

0120-90-5794

(平日 10:00~19:00)

グラッドキューブは

「ISMS認証」を取得しています。

認証範囲:

インターネットマーケティング支援事業、インターネットASPサービスの提供、コンテンツメディア事業

「ISMS認証」とは、財団法人・日本情報処理開発協会が定めた企業の情報情報セキュリティマネジメントシステムの評価制度です。